Tweets zorgen niet voor betere posities!

“Ik ben er niet zeker van dat alleen tweets ervoor zullen zorgen dat je betere posities behaalt”, geeft David Naylor als antwoord op één van mijn vragen. Dit is een van de interessante uitspraken die ik in een serie interviews is horen kreeg. Omdat Search Engine Strategies 2011 London weer voor de deur staat (21 tot en met 25 februari), interviewde ik een aantal zeer interessante sprekers die een presentatie zullen geven op SES London: Dixon Jones, David Naylor en Mikkel deMib Svendsen.

Dixon Jones

Dixon Jones is Marketing Director van Majestic12 LTD oftewel Majestic SEO, eigenaar van een webbased technologie die wordt gebruikt door ’s werelds bekendste online marketeers om te analyseren hoe webpagina’s op het internet in relatie met elkaar staan als je kijkt naar de backlinks. Het is op dit moment de grootste database met backlinks die in het openbaar kan worden geanalyseerd. In totaal telt de Majestic SEO database nu sinds de laatste update 3,118,722,549,598 URL’s van 316,947,322,848 gespiderde pagina’s.

Op SES London spreekt Dixon Jones op dag 1 op track 1 om 16.00 uur over ‘How to become a link magnet’. ik vond dit een goede kans om Dixon eens iets meer te vragen over zijn sessie en over linkbuilding in het algemeen.

1. Hoe groot denk je dat op dit moment de impact is van social media factoren als ‘likes’ en ‘tweets’ op de resultaten van websites in de zoekresultaten?

Ik denk dat er een zeer groot verschil is tussen ‘Likes’ en ‘Tweets’. Voor zover ik het kan zien, doen ‘Likes’ op dit moment niet veel meer dan gebruikers de illusie geven dat ze met een website bezig zijn. Tot nu toe zie ik nog geen bewijs dat de rankings van een pagina de lucht in schieten omdat deze 20 ‘likes’ heeft gekregen. Tweets zijn een heel ander verhaal. Ik denk dat mensen alleen op links in tweets klikken als ze de gebruikers,website en de context van de tweet volledig vertrouwen. Daarom denk ik ook, vanwege de Twitter Fire-Hose (de real-time stroom van tweets) dat Google een duidelijk standpunt heeft gemaakt dat social media vanaf nu een onderdeel gaat uitmaken van hun algoritmes. Rishi Lakhani (@rishil) heeft tests uitgevoerd waarin naar voren kwam dat tweets al zeker gebruikt worden voor het vinden van nieuwe content door de zoekgigant. Helaas kon ik niet controleren of er geen gaten in zijn testen zaten, dus de ervaringen van anderen kunnen natuurlijk afwijken van zijn testen. Ondanks dat zorgt social media natuurlijk ook voor bezoekers naar je websites en dit alleen zal (als de bezoekers een positieve insteek hebben) toch ook een lift geven in zoekmachine exposure, óf door nieuwe links óf door het algoritme.

Toen Google zijn implementatie van Twitter-berichten live in de zoekmachineresultaten ging tonen, denk ik dat we het er allemaal over eens kunnen zijn dat dit niet een van de meest professionele implementaties was. Daarom ben ik ook blij dat ze dit uiteindelijk hebben teruggedraaid voordat het te opdringerig zou worden. Implementaties die subtieler zijn qua opzet zijn natuurlijk altijd welkom. Zelf zie ik links naar een website altijd als een stem voor die website binnen de context van waar die link af komt. Een persoon die al zijn vrienden via social media wil vertellen dat hij iets erg goed vindt (vrienden spam je over het algemeen niet) is in die context net zo goed als een link.

2. Welke grote plannen heeft Majestic SEO dit jaar om zijn database te kunnen filteren, zodat pagina’s zonder links en pagina’s die niet meer bestaan niet terugkomen in de rapporten?

Er is al enorm veel gedaan aan dit onderwerp, waarbij de ‘index update lag’ al vertraagd is van 6 weken naar 2 weken in 2010. Maar er staat nog een hoop op de agenda rondom dit onderwerp. Natuurlijk moet ik oppassen om toezeggingen te doen over ontwikkelingen in de toekomst, maar we werken enorm hard aan deze verbeteringen en hebben het bijna op orde. We hebben ook de laatste tijd veel verbeteringen aangebracht aan onze crawler technology die nu door het systeem is gegaan en die nu zichtbaar aan het worden is in de index. Zelf heb ik de laatste index doorgenomen en was zeer blij om te zien dat de beste links in de index gecontroleerd zijn tussen de crawls in, waarvan veel op de laatste dag, nog voordat we aan de nieuwe index zijn begonnen. Dit betekent dat je de links veel beter kunt filteren op basis van de laatste succesvolle crawl-datum, waardoor links die nog bestaan veel accurater zijn uit te filteren.

Daarnaast hebben we hard gewerkt aan onze fresh crawl results en ik hoop dat wanneer dit interview wordt geplaatst er al meer over bekend is geworden. Als iemand de laatste maanden de nieuwe link data van Majestic SEO niet heeft gezien, dan weet ik zeker dat hij blij verrast zal zijn over hoe de kwaliteit is verbeterd.

3. Als je zelf zou kunnen kiezen tussen alle link building tactieken, welke tactiek zou je zelf gebruiken voor je persoonlijke projecten om stabiele resultaten te behalen in de minste tijd?

Wegkomen met een gigantische offline ‘stunt’ die gefilmd is en op een blog is geplaatst op een manier dat YouTube het niet kan gebruiken/hosten, in combinatie met ervoor zorgen dat CNN en BBC er voorpaginanieuws van maken, zodat het viral gaat. Met andere woorden: als de linkbait werkt en blijft hangen, dan kan het goede resultaten opleveren. De truc is om te zorgen dat het werkt! Dat het blijft hangen is de volgende uitdaging. Daarom denk ik dat het zijn van een data autoriteit de beste strategie is. Elke keer dat je data worden ververst, zorgt ervoor dat je geciteerd wordt als de autoriteit achter deze data.

4. JavaScript links worden veel gebruikt voor het ‘sculpten van PageRank’ sinds de verandering van nofollow een tijd geleden. De meningen zijn verdeeld of deze links nu wel of geen waarde doorgeven aan de pagina waarnaar ze verwijzen.

Google kan al geruime tijd JavaScript links volgen (het ligt er natuurlijk wel aan hoe je deze JavaScript codeert) en Google wil deze links ook erg graag volgen. Het ziet er naar uit dat dit alleen wordt gebruikt voor het ontdekken van nieuwe links. Ik zie echter niet in waarom het alleen voor deze doeleinden gebruikt zou worden.

5. Welke verandering in link building voor 2011/2012 zal de meeste impact krijgen op de ROI van jouw klanten en projecten?

Als je kijkt naar meetbare ROI dan hebben social media links de potentie om de ROI écht drastisch te laten stijgen. Uiteindelijk staat of valt een link bij de kracht van de link, of het nou is om mensen naar de website te sturen of meer autoriteit te creëren. Zelf denk ik niet dat één bepaalde methodologie over de gehele linie correct zou zijn. Als we kijken naar nieuwe initiatieven dan kan het enorm effectief zijn om links te plaatsen naar mobiele versies van websites. Ik zou er niet van staan te kijken als mensen Android applicaties gaan maken die toegang hebben tot on-site code in de hoop dat de vriendelijke zoekmachinerobot dit allemaal gaat volgen. De echte reden waarom ik denk dat mobiele links erg van pas zouden komen, is omdat links op mobieltjes gemakkelijker te lezen zijn en daarom ook vaak een betere ankertekst hebben. Woorden zijn schaars op mobieltjes en ‘klik hier’ is daarom absoluut niet gebruikelijk en verstandig.

Daarnaast denk ik zeker dat Google de links in 2011 onder een microscoop gaat leggen. De zoekresultaten vangen steeds meer kritiek en ik denk dat Google ook weet dat links in hun huidige opzet een groot onderdeel van het probleem zijn. In 2011 moet de filosofie van een linkbuilder zijn dat de bezoekers die uit een geplaatste link komen ook in context staan met de verwachte relevantie van de link. De technologie is er nu om voor een zoekmachine ook te meten (of tenminste via samples) wat en hoeveel bezoekers er lopen tussen URL A en URL B. Deze bezoekers gaan altijd via een link of iets gelijkaardig. Dus als je een miljoen links hebt die allemaal geen bezoekers sturen, dan is het te verwachten dat ze niet zo lang meer mee zullen tellen.

Mikkel deMib Svendsen

Mikkel deMib Svendsen, Creative Director deMib.com, is al geruime tijd moderator op Search Engine Forums waar hij de forums ‘Dynamic pages’, ‘frames and stuff’ en ‘Non-English Search Engines’ voor zijn rekening neemt. Hij staat bekend om zijn autoriteit op het gebied van geavanceerde problemen met Flash, frames, dynamische content en cloaking. In zijn carrière heeft hij jarenlange ervaring met zoekmachines en SEO door zijn rol als manager van de grootste Scandinavische zoekmachine en als VP Product Development bij Ankiro, het grootste search bureau van Denemarken.

Mikkel deMib Svendsen, Creative Director deMib.com, is al geruime tijd moderator op Search Engine Forums waar hij de forums ‘Dynamic pages’, ‘frames and stuff’ en ‘Non-English Search Engines’ voor zijn rekening neemt. Hij staat bekend om zijn autoriteit op het gebied van geavanceerde problemen met Flash, frames, dynamische content en cloaking. In zijn carrière heeft hij jarenlange ervaring met zoekmachines en SEO door zijn rol als manager van de grootste Scandinavische zoekmachine en als VP Product Development bij Ankiro, het grootste search bureau van Denemarken.

Op SES London spreekt Mikkel deMib Svendsen op dag 2 op track 1 om 11.00 uur over ‘Marketing to the European Union’. De perfecte kans dus om Mikkel wat meer te vragen over zijn sessie en over SEO in het algemeen.

1. Wat vind je van het feit dat Google titels descriptions en dergelijke vertaalt in native talen van desbetreffende landen om te tonen in de SERPS? Verandert dit je tactieken voor klanten die in meer dan één land en met meer dan één taal actief zijn?

Automatische vertalingen converteren gebruikers niet in klant. Als je dit als strategie inzet is dit een hele slechte keuze. Lokale communicatie is niet alleen het vertalen van woorden. Het is ook van belang dat je je manier van uiten verandert naar de lokale markt, cultuur en de legale mogelijkheden en beperkingen. Zelf ben ik geen voorstander van de automatische vertalingen van Google. In het ergste geval zorgen ze zelfs voor uitingen die illegaal zijn, omdat iets in een ander land niet gezegd mag worden wat in het originele land geen probleem is.

2. Er is nog een hoop misinformatie rondom duplicate content. Veel mensen denken nog aan penalty’s en gehele pagina’s die in de sandbox zijn gegooid. Kun jij eens in het kort uitleggen hoe het wel werkt?

Er is een groot verschil tussen ‘penalty’s’ en ‘filters’. Normaal gesproken is er geen penalty geassocieerd met duplicate content. Echter wordt duplicate content wel standaard uit de index gefilterd of het krijgt een lagere waarde mee, wat uiteraard volkomen logisch is. Er zijn talloze soorten duplicate content: identieke pagina’s, identieke elementen, syndicaties van teksten en dan nog één miljoen andere technische reden waarom duplicate content kan ontstaan. Al deze vormen worden door de zoekmachines anders bekeken en behandeld. Als de zoekmachines URL’s vinden die naar hun zeggen dezelfde content of bijna dezelfde content bevatten, dan zullen ze vroeg of laat alles eruit filteren wat niet het origineel is. Andere zaken als context en link data spelen hier ook een rol in. Als de zoekmachines op een pagina dubbele elementen vinden, zullen ze over het algemeen alleen deze negeren. Duplicate content is een enorm complex gebied van SEO en het dus dieper dan dit uitleggen in een paar regels is onmogelijk.

3. Bing/Yahoo daar is het afgelopen jaar veel over gesproken. Echter zien we hier in Europa toch nog vrijwel geen wijzigingen in marktaandeel van de combinatie. Gaat het volgens jou gebeuren dat hier nog verandering in komt met deze combinatie?

Ja, ik ben ervan overtuigd dat Google het marktaandeel dat ze nu hebben niet vast kan houden. In sommige landen zoals Denemarken is het marktaandeel bijna 100%. De meeste sites waar ik aan werk geven 92-97% marktaandeel aan op dit moment. Er is geen enkel bedrijf in welke markt dan ook dat zo’n dominante positie kan vasthouden. De grootste vraag is wanneer het gaat gebeuren, en aan wie het gaat gebeuren. Ik ben zelf van mening dat Bing degene zal zijn naar wie dit zal gaan. Ik denk niet dat Yahoo! hier verder een grote rol in zal spelen. Ze hebben het zelf in vele Europese landen verpest: het managementteam in de VS snapte niet hoe ze de lokale adoptie moesten uitvoeren en wilde niet luisteren naar de goede lokale mensen die ze hadden. Ze gedroegen zich als arrogante Amerikanen.

5. Welke verandering in SEO voor 2011/2012 zal de meeste impact krijgen op de ROI van jouw klanten en projecten?

Ik zie op dit moment geen veranderingen die impact zullen hebben op de ROI.

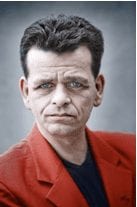

David Naylor

David Naylor, beter bekend als DaveN, is meer dan 12 jaar geleden begonnen met werken in de SEO-industrie. David zijn drijvende kracht is zijn geloof dat het geen nut heeft om een website te hebben als deze niet op nummer 1 staat. David is de eigenaar van Bronco Internet, een zeer succesvol webdesign- en developmentbedrijf, dat zijn specialiteit kent in e-commerce oplossingen en veelbesproken state of the art programmeerwerk. Deze combinatie biedt klanten dus niet alleen zoekmachineoptimalisatie maar een compleet pakket websitedesign, programmering en webhosting oplossingen.

David Naylor, beter bekend als DaveN, is meer dan 12 jaar geleden begonnen met werken in de SEO-industrie. David zijn drijvende kracht is zijn geloof dat het geen nut heeft om een website te hebben als deze niet op nummer 1 staat. David is de eigenaar van Bronco Internet, een zeer succesvol webdesign- en developmentbedrijf, dat zijn specialiteit kent in e-commerce oplossingen en veelbesproken state of the art programmeerwerk. Deze combinatie biedt klanten dus niet alleen zoekmachineoptimalisatie maar een compleet pakket websitedesign, programmering en webhosting oplossingen.

David zijn eigen weblog trekt een wereldpubliek en hij staat bekend om zijn down to earth en informatieve insteek over alle zaken rondom SEO. Hij loopt voorop bij de laatste nieuwtjes op SEO-gebied en daardoor is hij een autoriteit binnen de SEO-community.

Op SES London spreekt David Naylor op dag 1 op track 1 om 13.15 uur over ‘Introduction to SEO’. Tijd dus om David aan de tand te voelen over wat lopende SEO vraagstukken.

1. Hoe groot denk je dat op dit moment de impact is van social media factoren als ‘likes’ en ‘tweets’ op de resultaten van websites in de zoekresultaten?

Ik ben er niet zeker van dat tweets alleen er voor zullen zorgen dat je betere posities behaalt. Echter vind ik wel dat een website de correcte inkomende signalen nodig heeft, en social is een positief signaal. Maar als er sterke relevante websites zijn met goede paginafactoren, backlinks en autoriteit dan zal het weinig effect hebben op de SERPS.

Kijk maar naar de recente ‘clashes break out in Tahrir Square’ zoekopdracht. Aljazeera.net had een live stream lopen van dit evenement, maar rankte nog niet in de top-20 op die zoekterm. De stream-pagina was een PR8 maar de onpage factoren zoals de <h1> waren ‘Al Jazeera English: Live Stream’. De top-20 was vol bezaaid met forums en Twitter-berichten die allemaal naar die Al Jazeera live stream linkten.

2. Welke tactieken gebruik je om een goede ROI te halen voor klanten die niet lokaal gebaseerd zijn? Als voorbeeld ‘schoenen’, die als SERP nu zo goed als alleen maar lokale resultaten laat zien boven de vouw. Als de klant geen fysieke shops heeft op locatie, hoe ga je dan verder?

Dit is moeilijk, maar ik heb al vreemde zaken gezien, die misschien eens wat dieper bekeken kunnen worden, zoals de Office.co.uk (geen klant) posities. Door het veranderen van je locatie in Google kun je een betere kijk krijgen op welke posities beschikbaar zijn in welke regio’s. Misschien kan een lokale-/ staddatabase in combinatie met een python script hier helpen. Natuurlijk is het ook altijd mogelijk om Map-resultaten te triggeren op basis van een postadres. En voor steden waar veel gezocht wordt op deze woorden, kan je altijd een postbus nemen om op die manier Maps te triggeren.

3. Wat vind je van het feit dat Google titels, descriptions en dergelijke vertaalt in native talen van desbetreffende landen om te tonen in de SERPS? Verandert dit je tactieken voor klanten die in meer dan één land en met meer dan één taal actief zijn?

Persoonlijk ben ik het nog niet live tegengekomen, maar het is natuurlijk wel heel vreemd als je als gebruiker dan op een Engelse website uit zou komen nadat je een Duitse zoekopdracht hebt uitgevoerd. Ik zou echt niet weten wat ik dan zou moeten doen, behalve de ‘back’ button te gebruiken. Voor onze klanten ben ik een groot voorstander van de lokale Tld, maar dan heb je wel een eigen budget nodig voor elke Tld. Eén ding dat Google web gedaan heeft om lokalisatie gemakkelijker te maken, is de geo-targetting in het Google Webmaster Centrum. Daarom gebruik ik nu steeds vaker subfolders (/en/ voor Engels, /de/ voor Duitsland) om de juiste talen weg te zetten.

4. JavaScript links worden veel gebruikt voor het ‘sculpten van PageRank’ sinds de verandering van nofollow een tijd geleden. De meningen zijn verdeeld of deze links nu wel of geen waarde doorgeven aan de pagina waarnaar ze verwijzen.

Ik heb nog geen bewijs gezien dat JS onclicks ook maar enige waarde doorgeven. Maar ik ben wel een groot voorstander om uren te besteden aan het krijgen van één hele goede link in plaats van uren te besteden aan het sculpten van PageRank binnen mijn eigen website.

5. Welke verandering in SEO voor 2011/2012 zal de meeste impact krijgen op de ROI van jouw klanten en projecten?

Meer Google web properties is voor mij de grootste zorg om eerlijk te zijn. Toen zeer recent Google Places uitrolde was ik toch wel bezorgd voor één klant die met zijn producten binnen de ‘lokale’ producten viel. Echter hebben we tot nu toe nog geen verlies in bezoekers geconstateerd.

De antwoorden op bovenstaande vragen lopen dus nogal uiteen en zo zie je maar weer dat in het land van zoekmachineoptimalisatie en linkbuilding niet iedereen het eens is over hoe bepaalde zaken wel of niet werken. Kijk daarom ook altijd naar je eigen ervaringen en specifieke projecteigenschappen die van invloed kunnen zijn op het resultaat. Denk altijd voordat je iets gaat doen: gaat dit het verschil maken waar ik naar op zoek ben voor de klant?

Employee Experience

Employee Experience