Wanneer & waarom A/B-tests zinloos zijn

Iedereen wil A/B testen tegenwoordig. Maar helaas is het niet altijd zinvol. Het kan zelfs een enorme verspilling van je tijd (en bezoekers) zijn. Begrijp me niet verkeerd: bij Yorro zijn we gek op A/B testen. We doen het voortdurend. Maar alleen als het zinvol is. In dit artikel leg ik uit wanneer en waarom A/B-tests zinloos zijn.

Conversieoptimalisatie ≠ A/B testing

Eerst en vooral: ik zie heel wat mensen de termen ‘conversieoptimalisatie’ en ‘A/B testing’ door elkaar halen. Veel mensen denken dat ze hetzelfde zijn. Het is een veelvoorkomende en begrijpelijke fout.

Maar conversieoptimalisatie is zoveel meer dan dat. A/B testen is een eindpunt, nooit een beginpunt. Om het duidelijker te maken, dit is de formule die we hanteren:

Conversieoptimalisatie = onderzoek + implementatie (+ testing)

Ja, testing staat tussen haakjes in deze formule. Dat betekent dat testing niet altijd een noodzakelijk onderdeel is van conversieoptimalisatie.

Je hebt voldoende verkeer en conversies nodig

Ik praat vaak met mensen die ergens opgevangen hebben dat ze niet genoeg verkeer hebben voor conversieoptimalisatie. Meestal bedoelen ze: ze hebben niet genoeg verkeer voor A/B-tests. Maar dat betekent niet dat je geen conversieoptimalisatie kunt doen. Zelfs met slechts een handvol bezoekers op je site kun je je site optimaliseren voor meer conversies. Je beperkt je dan tot research en implementatie. En laat het testgedeelte achterwege.

Hoeveel verkeer heb je nodig om te testen?

Ok, je hebt best wel wat verkeer nodig om te testen. Maar het is eigenlijk iets handiger om het uit te drukken in aantal conversies dan in aantal bezoekers.

Vuistregel: je hebt minstens 1000 conversies per maand nodig om te testen. En liefst nog meer. De reden hiervoor is eenvoudig: als je minder conversies hebt, dan moeten je tests veel te lang lopen voor ze statistisch significant zijn.

Vuistregel: je hebt minstens 1000 conversies per maand nodig om te testen. En liefst nog meer.

Om zinvolle conclusies uit je tests te kunnen trekken, heb je al gauw zo’n 200 tot 250 conversies voor elke variatie nodig. Met andere woorden: je hebt 200-250 conversies nodig voor Control (of je A-versie) en 200-250 conversies voor Variation 1 (of je B-versie). Als je slechts 200 conversies per maand hebt op je site, zou je dus al snel 2 maanden moeten testen voordat je test afgelopen is. Een gigantische verspilling van je tijd en bezoekers.

Je hebt genoeg conversies nodig om de segmenten te analyseren

Als je je test in bepaalde segmenten wil analyseren, heb je nog meer conversies nodig. Want dan heb je 200-250 conversies nodig in elk van de segmenten, zowel voor de A- als de B-versie in je test.

Je segmenten analyseren kan erg interessant zijn, want je kunt er veel uit leren. Het gebeurt ook vaak dat je globaal geen significant verschil ziet tussen de A- en B-versie. Maar wanneer je de test in de segmenten analyseert, dan vind je soms een winnaar in één van die segmenten. Dan kun je de winnaar voor dat segment implementeren zodat je je omzet kunt maximaliseren.

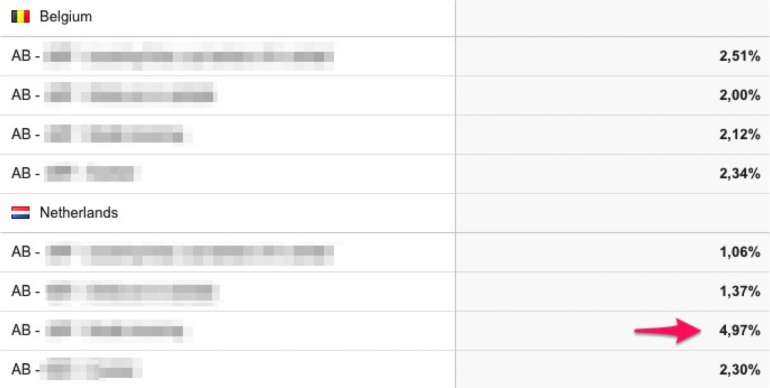

Kijk even naar dit voorbeeld. Dit was een A/B/C/D-test die we gedaan hebben voor een Belgische site die ook veel bezoekers uit Nederland had.

Je ziet hier dat 1 variant bij Nederlandse bezoekers duidelijk een stuk beter presteerde dan de ander varianten. Globaal gezien zagen we bij deze test geen verschil tussen de 4 varianten.

Op basis van IP-adres tonen we nu die winnende variant aan alle Nederlandse bezoekers. Deze kans om de omzet te maximaliseren zouden we gemist hebben, als we de test niet in verschillende segmenten geanalyseerd hadden. Maar om dat te kunnen doen, heb je dus wel voldoende conversies nodig.

Hoe je – in sommige gevallen – kunt testen met minder conversies

Wat als je geen 1000+ conversies hebt per maand? Dan kun je met iets minder conversies (b.v. 500 – 1000 per maand) ook wel testen. Maar dan moet je eerder kijken naar je pagina-doelen, niet zozeer naar je site-doelen.

Stel dat je wil testen op de productpagina’s van je webshop. Het doel van die pagina is de bezoekers iets aan hun winkelwagen laten toevoegen. Er zullen veel meer bezoekers zijn die wat aan hun winkelwagen toevoegen, dan dat er bezoekers zijn die de uiteindelijke conversie (de transactie) zullen voltooien. Want doorgaans verlies je nog zo’n 50% van je bezoekers op de winkelwagen en in de checkout. De conversie die je in dit geval beter meet voor je A/B-test, is dus het toevoegen aan de winkelwagen en niet de transactie.

Het enige nadeel van paginadoelen is dat er mogelijk geen oorzakelijk verband is tussen je paginadoel en je omzet. De B-versie kan met andere woorden misschien wel zorgen voor meer toevoegingen aan de winkelwagen, maar dat betekent niet altijd dat je omzet er door zal stijgen.

Nauwelijks genoeg verkeer om te testen? Durf meer.

Als je maar net genoeg verkeer en conversies hebt om te testen, dan heeft het geen zin om elke kleine wijziging op je pagina’s te testen. Het duurt dan te lang voordat je ze allemaal getest hebt.

Hier is maar 1 oplossing voor: test grotere, gewaagdere veranderingen. Die zullen grotere verschillen opleveren (in de positieve of de negatieve zin).

Wat je kunt doen als je niet genoeg verkeer hebt om te testen

Het mooie aan de formule “Conversie optimalisatie = onderzoek + implementatie (+ testing)” is dat hij ook meteen toont wat je wél kunt doen als je niet genoeg verkeer hebt om te testen.

Je kunt je site optimaliseren door conversieonderzoek te doen en gewoon de zaken te implementeren die je in het onderzoek hebt ontdekt. Als je voldoende verkeer en conversies zou hebben, dan zou je door te A/B testen zaken gevonden die je conversies niet verbeteren of zelfs schaden en die je dus beter niet implementeert. Maar je hebt nu eenmaal niet voldoende traffic en dan moet je gewoon de ballen hebben om alle bevindingen uit je onderzoek te implementeren. Al die zaken samen zullen een positieve impact hebben, daar kun je vanop aan.

Test nooit zonder onderzoek

Laten we de formule er nog eens bijhalen:

Conversieoptimalisatie = onderzoek + implementatie (+ testing)

Het is geen toeval dat de woorden in deze volgorde staan. Als je je site wil optimaliseren, moet je eerst een gedegen onderzoek doen. Want hoe kun je anders weten wat je moet implementeren (en eventueel testen)? Door te gissen? Dat werkt niet. Je kunt niet raden wat geoptimaliseerd moet worden, je moet het WETEN.

Ongeveer 2 jaar geleden kwam een klant bij ons die al enkele zaken aan het wijzigen was op zijn productpagina’s om te proberen de conversieratio te verbeteren. Maar toen we het conversieonderzoek deden, bleek al snel dat ze meer dan 2.750.000 euro per jaar aan het verliezen waren op een bepaalde pagina in de checkout. En ze waren zich er niet eens van bewust. We zagen in Analytics dat heel wat mensen afhaakten in het bestelproces. Dankzij het kwalitatieve onderzoek kregen we beter inzicht in de reden waarom. Ze haakten af, omdat ze een keuze voor de levering van hun product moesten maken. Die keuze zorgde voor behoorlijk wat keuzestress, waardoor veel kopers op dat punt liever de site verlieten dan een keuze te moeten maken.

Eerst onderzoek

Zelfs al heb je genoeg verkeer en conversies om te testen, dan nog moet je eerst het conversieonderzoek uitvoeren. Uit onderzoek blijkt dat slechts 1 op 7 tests gemiddeld een statistisch significant resultaat oplevert. Dat is bitter weinig. Maar als je eerst je research doet, dan kun je verwachten dat je ongeveer bij 1 op 3 tests een significant resultaat krijgt. Dat betekent dat je de tijd die je eerst aan het onderzoek wijdt, heel snel inhaalt en dat je omzet een stuk sneller zal toenemen omdat je sneller winnaars vindt dankzij het onderzoek.

Test niet alles

Nogmaals de formule (voor de laatste keer, ik beloof het):

Conversieoptimalisatie = onderzoek + implementatie (+ testing)

Na het onderzoek volgt de implementatie. Dat betekent dat je in het onderzoek dingen zult ontdekken die je niet moet testen, ook al heb je er genoeg verkeer en conversies voor. Sommige zaken zijn nu eenmaal no-brainers die je zo kunt implementeren zonder dat je ze moet testen.

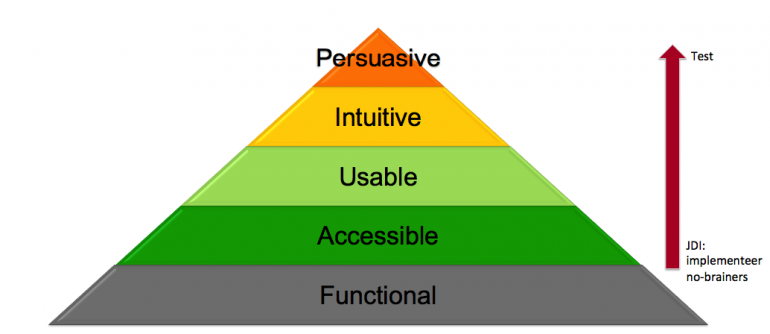

Hiërarchie van conversies

Om te bepalen wat een een no-brainer is en wat je moet testen, kun je deze ‘hiërarchie van conversies’ erbij nemen:

Als je het onderzoek doet, zul je kansen voor optimalisatie vinden op verschillende vlakken:

- Functional: bijv. je hebt technische problemen op een bepaalde browser

- Accessible: bijv. de checkout wordt op mobiel niet correct vertoond

- Usable: bijv. je site is erg langzaam

- Intuitive: bijv. je checkout flow is niet logisch

- Persuasive: bijv. je moet je copy beter maken om je bezoeker te overtuigen

Hoe hoger in de piramide, hoe zinvoller om te testen

De vuistregel is hier: hoe hoger in de piramide, hoe zinvoller het is om te testen. Hoe lager hoe zinlozer. Als je site bijvoorbeeld niet werkt op een bepaalde browser, is het uiteraard zinloos om te testen. Dat moet je gewoon fiksen.

Trouwens, zorg ervoor dat je eerst de onderste lagen van de piramide op orde hebt voordat je leuke psychologische en persuasieve elementen gaat testen. Schaarste creëren kan inderdaad werken, maar zal je niet veel helpen als je checkout niet werkt op Firefox.

Test geen button-kleur

Ugh, button-kleur. Het is zo’n cliché in conversieoptimalisatie dat ik er een aparte paragraaf aan wijd. Er lijkt een mythe te bestaan dat er zoiets is als 1 kleur die het best werkt op elke site. Die mythe is gegroeid uit zinloze case studies waarin een bepaalde site bij een A/B-test ontdekte dat groen beter werkte voor hen. En dus ging iedereen die dat las vrolijk zijn buttons aanpassen naar groen. Of oranje. Of whatever die bepaalde case study zei.

Dat is natuurlijk nonsens. De beste button kleur verschilt van site tot site en wordt bepaald door de dominante kleur op je site. Is rood de dominante kleur? Dan kan een groene button inderdaad beter werken. Omdat ‘ie gewoon meer opvalt tussen al dat rood. Is groen de dominante kleur op je site? Dan zal rood beter werken. Of paars. Opnieuw: omdat het meer opvalt. Meer is het niet.

Verspilling van je tijd

Wij testen geen button-kleur. Nooit. Het is gewoon een verspilling van je tijd en traffic. Kies een kleur die contrasteert met de rest van je site zodat je buttons beter opvallen. Klaar. Geen A/B-test nodig.

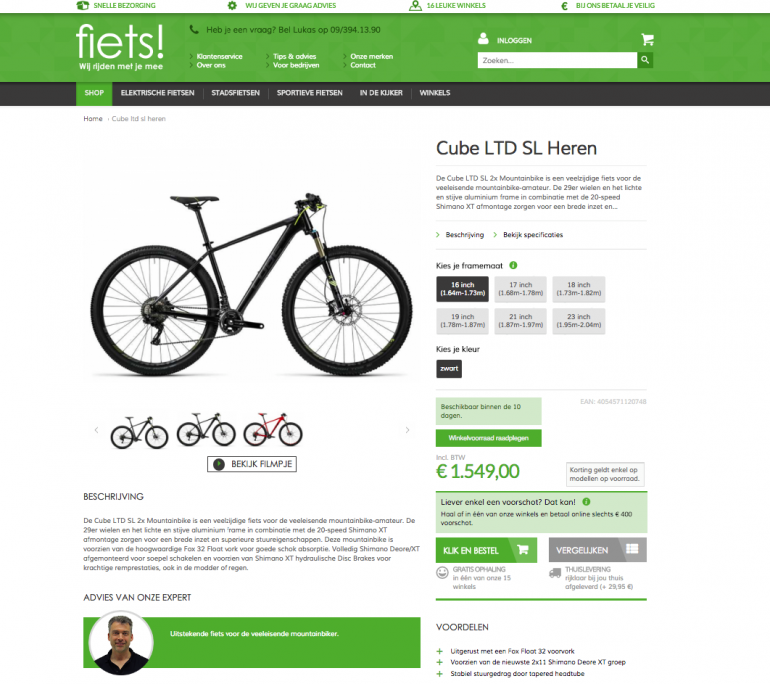

Ter illustratie, dit is de huidige productpagina op fiets.be. Zie jij nog de groene bestel-button?

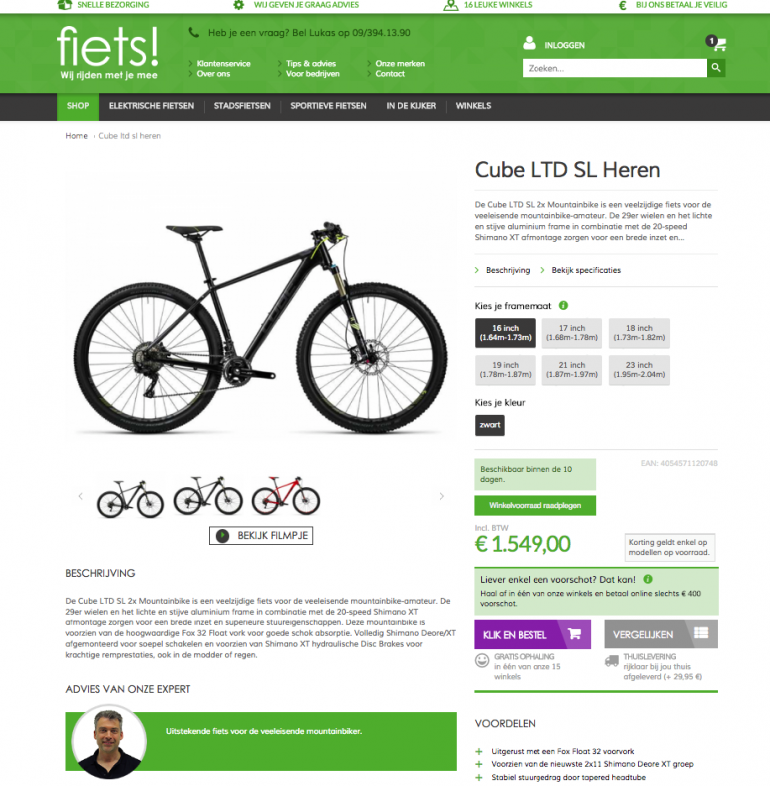

Laten we de belangrijkste button even een contrasterend kleur geven. Veel duidelijker, toch?

Kortom, om te weten of je moet A/B testen of niet, stel jezelf de volgende vragen:

- Hebben we genoeg verkeer en conversies om te testen?

- Hebben we eerst onderzoek gedaan?

- Is het een no-brainer (laag in de hiërarchie van conversies) die we gewoon kunnen implementeren?

- Is het een button-kleur? 😉