Het gevaar van kunstmatige intelligentie

Artificial intelligence (AI, kunstmatige intelligentie) wordt steeds breder toegepast, zowel zichtbaar (zelfrijdende auto’s) als onzichtbaar (prijsbepaling, fraude-detectie, beoordeling van mensen). Met name de nieuwe onzichtbare toepassingen zijn vaak problematisch: slecht werkende technologie wordt getest op echte mensen.

Achtergrond kunstmatige intelligentie

Het vakgebied kunstmatige intelligentie bestaat al meer dan 60 jaar. De Dartmouth-conferentie uit 1956 wordt vaak als startpunt van het vakgebied genomen. Zelf ben ik sinds 1997 actief op dit gebied, maar met een gezonde dosis scepsis. AI is interessant in het laboratorium en voor onderzoek, maar in veel gevallen niet bruikbaar in de echte wereld. Computers kunnen al jaren schaken en logica gebruiken, maar hebben veel moeite met taken die kinderen eenvoudig vinden: spreken, luisteren, lopen. Het risico dat dure robots uit zichzelf kapot gaan is nog altijd vele malen groter dan dat robots de wereld gaan overnemen.

Angst voor AI bestaat is er desondanks wel, gebaseerd op fictie: de film Terminator uit 1984 was voor veel mensen een eerste uitleg over mogelijke gevaren van ‘rogue AI’. In de praktijk viel de AI tegen en de gevaren mee. De bestaande algoritmes deden het zelden beter dan mensen, door een gebrek aan rekenkracht maar vooral ook trainingsdata. Het op grote schaal opnemen van echte data was simpelweg niet haalbaar.

Stroomversnelling

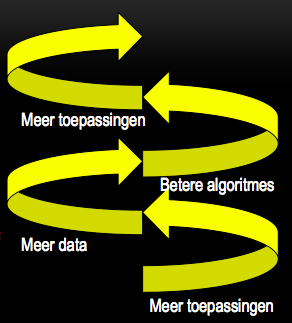

Sinds ongeveer 2005 is het vakgebied in een stroomversnelling gekomen. Door de opkomst van nieuwe krachtige GPU’s gingen de algoritmes het beter doen. Dit leidde tot grotere uitrol en daardoor tot beschikbaarheid van meer data. Dit leidde tot nog betere resultaten et cetera, et cetera. Het resultaat is dat AI nu veel meer echt wordt gebruikt. Denk aan Google Translate, beeldherkenning, of slimme security-algoritmes. Er lijken echte doorbraken te komen in het praktijkgebruik.

Veel grote bedrijven doen daarom nu onderzoek naar AI om de boot niet te missen. Nieuwe producten als auto’s worden daarom alvast voorzien van slimme sensoren, om data te verzamelen voor AI-toepassingen. Energiebedrijven hebben slimme meters geïnstalleerd, websites hebben trackers en dankzij de smartphone is ook locatie-data nu eenvoudig op te nemen. Het ontwikkelen van nieuwe AI wordt met deze nieuwe databronnen eenvoudiger en het is dus de verwachting dat de ontwikkelingen de komende jaren veel sneller zullen gaan dan in de afgelopen jaren.

De toepassingen worden ook echt volwassen. Kijk bijvoorbeeld naar dit onderzoek naar kunstmatige video uit 2017. Op basis van bestaande speeches van Barack Obama, of elke andere bekende persoon, kan men video’s maken die niet van echt te onderscheiden zijn. Met behulp van AI kun je dus nep-video’s produceren. Het is niet meer te zien dat er AI is gebruikt. Het risico op misbruik en manipulatie is dus zeker aanwezig.

Kamervragen en kritiek

Ook andere nieuwe toepassingen leiden echter tot ongewenste situaties. Gelukkig zijn er kritische politici. Tweede Kamerlid Rens Raemakers stelde in april 2018 Kamervragen over de algoritmes die gebruikt worden om bijstandsfraude te vinden. Dit soort fraude-algoritmes worden vaak geheim gehouden om fraudeurs niet te helpen. Het is echter belangrijk dat de uitkomsten en beslissingen van dit soort algoritmes controleerbaar zijn. Transparantie is nodig en het is goed dat de Tweede Kamer zijn werk doet en vragen stelt.

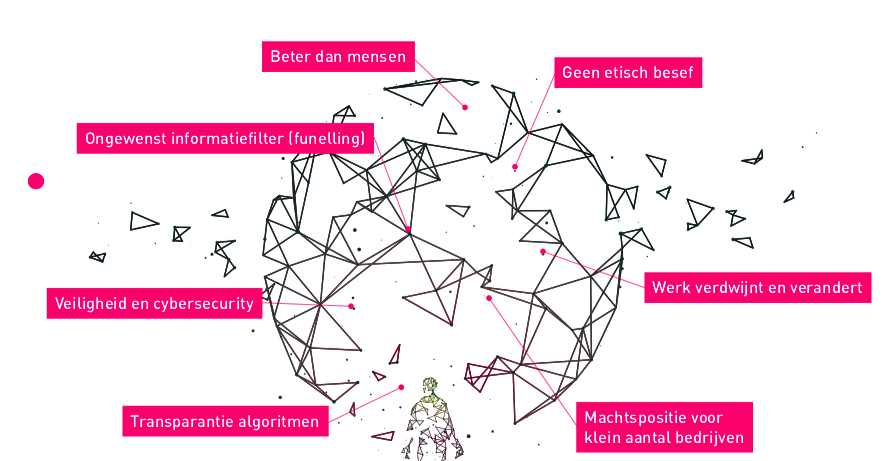

Ook het ECP heeft een goede bijdrage geleverd, door middel van een whitepaper: Artificial Intelligence: Gespreksstof en handvatten voor een evenwichtige inbedding in de samenleving (pdf). Dit is een goede, niet-technische introductie voor de maatschappelijke vraagstukken. Zo noemt ECP bijvoorbeeld funneling, de machtspositie van bedrijven, ethiek en transparantie als belangrijke uitdagingen.

Ook internationaal maakt men zich zorgen. Het AI Now Institute uit New York is in april 2018 gekomen met een eerste advies-rapport. Centraal ook hier is het belang van goede toetsing van nieuwe AI-toepassingen.

De oplossing: Algoritme Impact Assessment

Er is geen directe technische fix voor eerlijke algoritmes. Bij elke AI-toepassing waarbij algoritmes een bijdrage leveren, is er een kans op bijwerkingen. Niemand wil ook AI of algoritmes volledig verbieden. Gelukkig kunnen veel problemen voorkomen worden door het doen van een goed impact assessment. Voordat een algoritme in de praktijk gebruikt wordt, moet er een toets gedaan worden. Hierin moet het volgende worden bekeken:

- Hoe goed is het algoritme getest? Is de gebruikte testdata representatief?

- Zit er voldoende handmatige controle in het proces? Worden negatieve besluiten altijd gereviewd?

- Welke data wordt er verzameld en gebruikt voor deze toepassing? Weegt de waarde van de toepassing op tegen de privacy-inbreuk en risico’s?

- Wie is de eigenaar van het algoritme en wie van de data? Is dit een commercieel bedrijf met commerciële belangen? Gaat dit bedrijf zich aan de Nederlandse wet houden?

Bij het assessment moeten AI-onderzoekers betrokken worden, maar ook domeinspecialisten en het liefst ook vertegenwoordigers van de groep mensen op wie het algoritme wordt toegepast. De uitkomsten van het assessment moeten openbaar zijn, zodat journalisten, politici en burgers ook inzicht hebben in de uitkomsten. Waarschijnlijk moet het assessment regelmatig worden bijgewerkt, omdat AI-algoritmes vaak van nieuwe data en instellingen worden voorzien.

AVG en privacy impact assessment

De Algoritme Impact Assessment is helaas niet verplicht, maar gelukkig is er wel iets dat er op lijkt. Dankzij de nieuwe privacywetgeving (AVG of GDPR) is het al bij veel projecten verplicht om naar privacy te kijken. Er moet een Data Protection Impact Assessment (DPIA) worden gedaan (zie hier een template voor de inhoud van zo’n assessment).

Helaas zijn deze DPIA’s vaak niet openbaar en is het niet verplicht om hierin ook naar de details van de algoritmes te kijken. Hopelijk worden de richtlijnen uitgebreid en de regels aangepast, zodat deze impact assessment openbaar worden. Alleen op deze manier houden we als samenleving grip op kunstmatige intelligentie.