De risico’s van deepfake-technologie

Met de komst van deepfake-technologie breekt een tijdperk van nieuwe online bedreigingen aan. Ik laat een paar voorbeelden zien van hoe deepfake ons persoonlijk kan schaden. Daarna deel ik in dit artikel hoe de maatschappij als geheel getroffen kan worden door nepinformatie die met kunstmatige intelligentie is gevormd.

Al bijna drie decennia gebruiken we op grote schaal e-mail. Iedereen is inmiddels bekend met phishing, spam en andere hinderlijke acties. De mogelijkheden van internet-fraude en andere vormen van internet-criminaliteit nemen steeds meer toe.

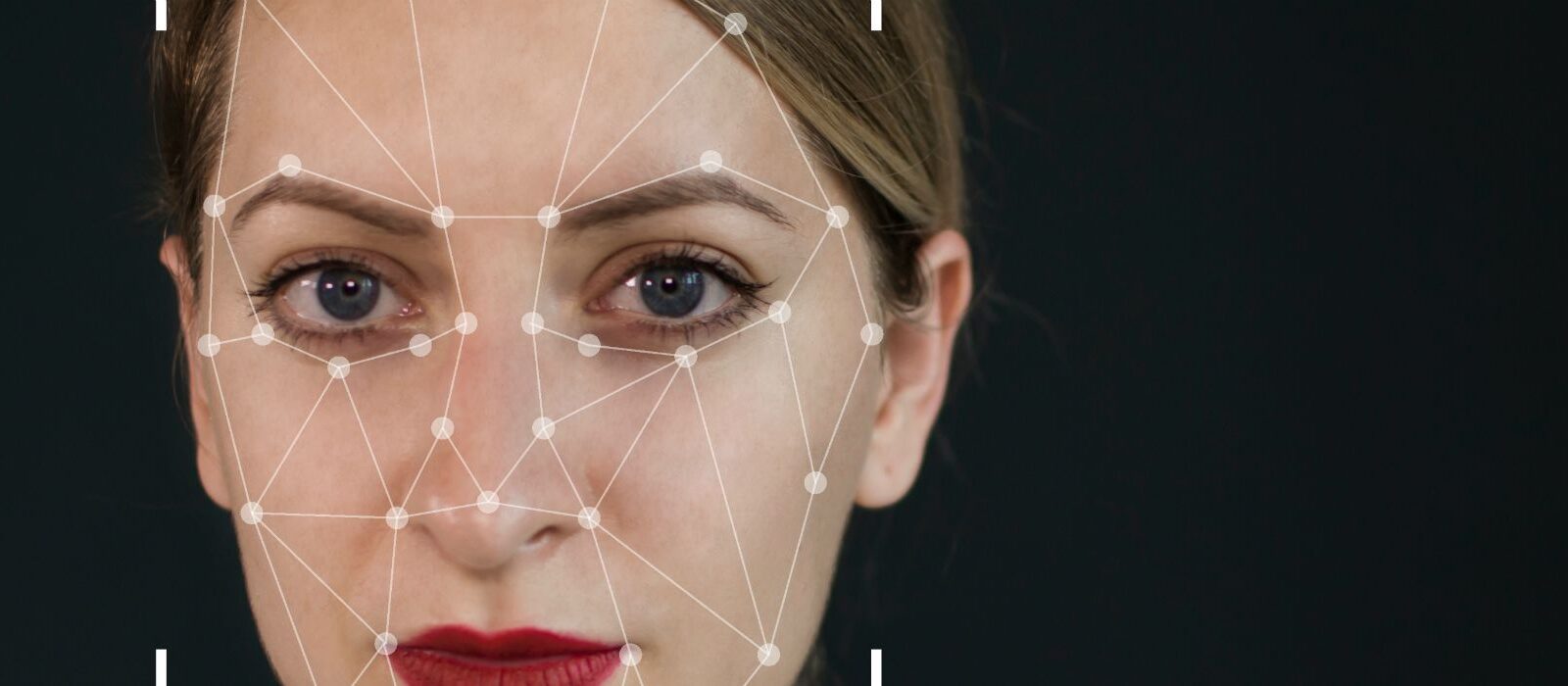

Deepfake-technologie

Toch is dat nog maar kinderspel vergeleken bij de bedreigingen die ontstaan door deepfake. ‘Deepfakes’ zijn teksten, beelden, video’s en audio-bewerkingen die door kunstmatige intelligente software zijn gecreëerd. We betreden daarmee een online tijdperk waarin we onze ogen en oren niet meer kunnen vertrouwen. Deepfake-technologie brengt het begrip nep-informatie op een hoger niveau. Met helaas een aantal negatieve gevolgen.

Identiteitsfraude

Onlangs ontving de CEO van een Brits energiebedrijf bijvoorbeeld een voicemail vanuit Duitsland. Hij was ervan overtuigd dat hij met zijn leidinggevende bij het Duitse moederbedrijf te maken had. Zelfs het accent was onmiskenbaar. Of hij even geld wilde overmaken naar een Hongaarse rekening. Plichtsgetrouw als hij was, deed hij dat onmiddellijk. De stem van de CEO was echter gegenereerd door een kunstmatig intelligent systeem: een voice cloning deepfake.

Er zijn vele toekomstscenario’s denkbaar waarin een voice cloning-opname van iemands stem kan worden misbruikt. Denk aan het ontfrutselen van persoonlijke informatie voor een latere cyberhack of een rechtstreekse fraude-aanval, bijvoorbeeld met een gesproken WhatsApp bericht:

“Hey hallo met Jarno, ik bel even met een andere telefoon omdat mijn iPhone kapot is en nu sta ik voor de deur van ons nieuwe kantoor, wat is ook alweer de entree-code? Die staat namelijk ook in mijn iPhone. App ‘m maar even, dankjewel!”

Misleiden van de digitale assistent

Ook de digitale assistent in huis, waaraan je gesproken opdrachten geeft, laat zich waarschijnlijk foppen met zo’n gekloonde stem. Wat als een deepfake-stem die assistent misleidt en zo toegang krijgt tot je agenda, je lijst met contacten, je e-mail en je bankrekening?

- “Alexa, maak $350 over aan het volgende rekeningnummer”

- “Alexa, stuur een bericht naar Harold waarin je hem vraagt de reis naar China te annuleren”

- “Alexa, verwijder alle afspraken uit mijn agenda tot 1 september”

Aangezien wij steeds meer met stembesturing onze apparaten en software bedienen, is bovenstaand scenario gevaarlijk én niet onwaarschijnlijk.

Reputatieschade

Deepfake-informatie, via spraak, beeldinformatie of anderszins, kan ook je reputatie danig aantasten. En dat is ernstig, want een goede, vaak zorgvuldig opgebouwde reputatie is veel waard. Stel je je eens voor dat zo’n fake stem je in een video of podcast dingen laat zeggen die politiek of maatschappelijk absoluut niet door de beugel kunnen. Bewijs maar eens dat het nep is.

Fake video’s waarin je figureert, kunnen bijzonder compromitterend zijn. Ze kunnen, zelfs als ze aantoonbaar nep zijn, voor eeuwig rondzwerven op social media en blijvend je reputatie schaden. Voor de buitenwacht geldt al snel: waar rook is, is vuur. Alleen al de suggestie heeft verstrekkende gevolgen. En het kost je vervolgens enorm veel tijd en energie om je van alle blaam te zuiveren, als dat al lukt.

Chantage

Nog beangstigender is het dat alleen al de dreiging van deepfake-video’s een chantagemiddel kan zijn. Het idee dat zo’n video in omloop wordt gebracht, kan iemand radeloos maken. Een vroeg voorbeeld daarvan is de deepfakeporn-video, waarvoor een tool op het Reddit-forum stond. Dat software-gereedschap verving gezichten van pornoactrices in video’s door gezichten van beroemde vrouwen.

Niet alleen beroemde mensen zijn kwetsbaar voor zulk misbruik. Een dergelijke tool kan ook worden ingezet voor het maken van wraakporno, nadat een relatie op de klippen is gelopen.

Het maken van een fake video is ook nog eens relatief eenvoudig. Alle ingrediënten staan in feite al klaar. Trendwatcher Sander Duivestein verklaart in mijn rapport ‘Machines met verbeeldingskracht’: “Het maken van een nepvideo met deepfakes wordt net zo gemakkelijk als het vertellen van een leugen.” Koppel dat met de razendsnelle verspreiding van een video via social media en de aanwezigheid van volop geïnteresseerd publiek, en het leed is geschied.

Liar’s dividend

Deepfake-technologie kan ons dus allemaal persoonlijk raken, maar ook de maatschappij als geheel is kwetsbaar. De afgelopen jaren is de term ‘fake news’ al ingeburgerd geraakt. Die uitdrukking verwijst dan vooral naar berichten die uit hun verband zijn gerukt of veronderstelde leugens.

Met de snelheid waarmee de deepfake-technologie zich ontwikkelt, moeten we niet vreemd opkijken als bijvoorbeeld politici binnen enkele jaren met hetzelfde gemak ongewenste video- of audio-opnamen afdoen als “deepfake news”. Zelfs als die opnamen honderd procent betrouwbaar zijn. Dat noemt men Liar’s dividend, het voordeel van de twijfel dat de leugenaar bijzonder goed uitkomt. Bewijslast tegen criminelen, bedrijven of overheid wordt in het tijdperk van deepfakes dus steeds minder waard.

Sociale onrust

Ook zullen er video-opnamen in omloop komen die de bedoeling hebben verdeeldheid te zaaien. Politiek gerichte deepfake-video-opnamen kunnen bijvoorbeeld een serieuze strategie zijn van het ene land om in een ander land verdeeldheid te zaaien. Video’s kunnen tegenstellingen aanwakkeren, de saamhorigheid aantasten en leiden tot een weifelende besluitvorming.

Dat tast het fundament van een democratische staat aan, want juist in een democratie moeten we het samen eens zijn over de gemeenschappelijk ervaren werkelijkheid. Ook al verschillen we van mening, dan nog zouden we niet hoeven te twijfelen over de feiten. Als dat fundament wegvalt door nepinformatie, komen we vaak niet eens toe aan het bedenken van oplossingen. Dit omdat we het niet eens zijn over wat dan precies de problemen zijn.

Einde van geloofwaardigheid

Deepfake-technologie kan ook valse teksten opleveren. Er bestaan al systemen die nepteksten produceren. Ze werken nog niet perfect, maar wellicht is dat een kwestie van tijd. Je hoeft zo’n systeem slechts een krantenkop te dicteren en daarna druk je simpelweg op een knop. Een korte tekst wordt dan gecreëerd door AI. Dat is werkelijk deepfake news. Als dat nieuws massaal via social media wordt verspreid, zaait dat twijfel over de betrouwbaarheid van al het nieuws dat ons bereikt. Of dat nu echt of nep is.

Stel dat een bepaalde groepering in Nederland de politie in een kwaad daglicht wil stellen. In de toekomst kan die met AI-software wellicht snel artikelen online zetten die zijn geschreven om het sentiment richting de politie negatief te beïnvloeden. Met gefantaseerde headlines als:

- ‘Politie grijpt hardhandig in bij vreedzame demonstratie tegen te tolerant immigratiebeleid’

- Demonstranten aangevallen door politiek gekleurde politieagenten bij vreedzame demonstratie Nederlandse Volkspartij’

- ‘Verbale en fysieke agressie door politie bij bijeenkomst in Den Haag’

Deze kunnen dan misschien razendsnel leiden tot geloofwaardige gegenereerde artikelen die de werkelijkheid geweld aandoen.

Razendsnelle verspreiding

Die massale verspreiding kan zeer snel verlopen. We klikken immers allemaal, als consumenten van social media, maar al te gretig op grappig, sappig, negatief, prikkelend of vooroordeelbevestigend nieuws. En we delen dat maar al te graag met elkaar. Dat delen doen we bij voorkeur binnen een groep van mensen die net zo in de wereld staan als wij, met dezelfde interesses en vooroordelen. Met een eenvoudige swipe of druk op de knop verspreiden we nieuws door alle platformen heen.

Informatie die ons (terecht of onterecht) bestaande wereldbeeld bevestigt, delen we sneller, zeker als die actueel en negatief van aard is. Dat geldt dus niet alleen voor echt nieuws, maar ook voor namaak.

Zelfs als deepfake-video’s en deepfake-teksten nooit het grote publiek bereiken, kunnen ze nog hardnekkig in de uithoeken van het internet blijven hangen en daar een gekleurd wereldbeeld versterken. Je kunt daarbij bijvoorbeeld denken aan aanhangers van een religieuze extremistische ideologie of anti-establishment-groeperingen.

Apathie

Hoe kan de consument, comfortabel binnen zijn filterbubbel, het onderscheid maken? En het verschil tussen nep en echt zien? Hoe reageert die consument als hij of zij beseft dat ‘eerst zien en dan geloven’ niet meer opgaat?

Het meest waarschijnlijke resultaat zal apathie zijn. Dat we een brede maatschappelijke ongevoeligheid ontwikkelen voor wat er zoal aan nieuws aan ons voorbijkomt, of dat nu echt is of nep. Een dergelijke ontwikkeling is slecht voor onze democratie. Daarin vervullen de vrije nieuwsgaring en de verspreiding van nieuws immers een essentiële rol.

Kans voor traditionele media

Daar ligt echter, om met een positieve noot af te sluiten, ook een kans voor de traditionele media. Meer dan ooit moeten zij als filter het onderscheid tussen echt en nep kunnen maken, en de nieuwsconsument van betrouwbaar nieuws voorzien. Of dat nu gedrukt, online of op televisie is. Wil je meer weten? Ik schreef een uitgebreid rapport over deepfake-technologie.