Betrapt! Hoe je AI van mensenwerk onderscheidt – en of je dat moet willen

Sinds ChatGPT lijken alle teksten wel verdacht, van scripties tot jurisprudentie en van beleidsdocumenten tot socialmedia-posts. Veel mensen willen checken of content door Artificial Intelligence (AI) is gegenereerd. Hieronder bespreek ik daarvoor handige tools en tips. Maar ik vraag me ook af: waarom willen we dat eigenlijk weten? En wanneer is dat relevant?

Eind vorige maand was ik op de European Collaboration Summit in Düsseldorf. Dat is één grote Microsoft-show, dus iedereen had het over Copilot, de AI-assistent die in alle Microsoft-apps komt. Wanneer? Dat wilde (of kon) niemand zeggen, maar november lijkt een goede gok. Ondertussen hebben we natuurlijk al ChatGPT, dat binnen twee maanden 100 miljoen gebruikers had (sneller dan TikTok!) en komen er dagelijks nieuwe AI-toepassingen bij.

Het is duidelijk: in sneltreinvaart gaan we naar een wereld, ook van werk, waarin het gebruik van generatieve AI wijdverbreid is. Dat is dus kunstmatige intelligentie die nieuwe content (teksten, plaatjes, video) kan genereren die in toenemende mate nauwelijks meer van mensenwerk te onderscheiden is. Probeer maar eens op Real Or Fake Text.

Om AI te herkennen zijn er wel tools en tips, die ik aan het einde van dit artikel bespreek. Maar de ontwikkelingen gaan zo snel dat die lijst al verouderd is als jullie dit lezen. Wat wel blijft zijn vraagstukken over waarom en wanneer je AI zou willen herkennen.

Student versus AI

Een van de sectoren waar het gebruik van generatieve AI nu al tot grote discussie leidt is het onderwijs. Ik sprak erover met Michiel Musterd, Manager Data, AI & Media bij het Learning & Innovation Centre van de Universiteit Leiden. Hij vertelde dat het gebruik door studenten van diensten als ChatGPT voor het schrijven van essays en scripties een snel groeiend fenomeen is. Aan officieel beleid hiervoor wordt hard gewerkt, maar voor een aantal docenten geldt nu al: door AI gegenereerd werk is onacceptabel, net als plagiaat.

Zelf denkt Michiel veel genuanceerder over deze kwestie. Hij ziet AI als een krachtige nieuwe tool voor studenten en docenten om hun werk te verbeteren en te versnellen. De moeilijkheid zit hem erin dat de huidige inrichting van onderwijs en vooral toetsing sterk is gericht op de beoordeling van studenten op geschreven werk. Dat veranderen is onontkoombaar, zegt Michiel, maar gaat ook veel tijd en energie vergen, terwijl de problemen acuut zijn.

De vertrouwenskwestie

Datzelfde geldt volgens mij voor veel kantoorbanen. Die bestaan voor een belangrijk deel uit het verzamelen, analyseren en rapporteren van informatie. Veel van dit werk kan in de nabije toekomst gedeeltelijk of zelfs grotendeels door AI worden gedaan. Optimisten, waar ik mezelf ook toe reken, denken dat werk daardoor leuker gaat worden en dat er allerlei nieuwe banen zullen ontstaan, hoewel dat niet zonder slag of stoot zal gaan. Maar de vraag is wel: vertrouwen we AI om taken van ons over te nemen?

Het antwoord lijkt voor veel mensen: nee. Uit onderzoek van KPMG blijkt dat in Nederland maar 37% van de respondenten vertrouwen heeft in AI op het werk, een van de laagste scores wereldwijd. Dit onderzoek is gedaan vlak voor de lancering van ChatGPT en het zou me niet verbazen als het vertrouwen na de apocalyptische mediahype daarover alleen maar is gedaald.

Voor een deel is dat wantrouwen ongetwijfeld te verklaren door de angst onze banen te verliezen, of zelfs de controle over ons leven. Maar zorgen over kwaliteit en traceerbaarheid van AI-content spelen ook een grote rol. Laten we dat eens wat beter bekijken.

Hoge lat of lage drempel?

We kennen allemaal de verhalen van hallucinerende AI, die met volledige overtuiging onzin uitkraamt. Het lijkt evident dat je daar niets belangrijks aan wilt overlaten. Maar uit recent onderzoek gepubliceerd in de toonaangevende Journal of the American Medical Association blijkt bijvoorbeeld dat AI betere antwoorden gaf dan artsen op een forum voor patiënten, en door hen ook als empathischer werd gezien.

Mensen maken natuurlijk net zo goed fouten en kramen soms aperte onzin uit. Moet de lat voor AI per se hoger liggen? Dodelijke ongelukken met Tesla’s op autopilot, ook een soort AI, worden breed uitgemeten, maar 9 van de 10 keer blijkt het om ‘gewone’ ongelukken te gaan. Hoeveel verkeersdoden (bijna 43.000 per jaar alleen al in de VS) zouden we juist kunnen voorkomen als we al die onoplettende, licht ontvlambare en soms beschonken bestuurders buiten spel zouden zetten?

Ik denk dat het met generatieve AI hetzelfde is. In de meeste gevallen zal gebruik ervan een betere tekst, plaatje of video opleveren dan als de mens het alleen had moeten doen. Dat zal ook de drempel verlagen om content te maken. Helemaal goed als het gaat om collega’s die hun kennis en ideeën makkelijker kunnen delen. Toegegeven: wel griezelig als bad actors het gebruiken om massa’s nepnieuws te genereren, maar ligt dat aan de AI?

Volgens mij moet altijd gelden dat de (menselijke) afzenders van content volledig verantwoordelijk zijn voor de inhoud.

Met wie spreek ik?

Het belangrijkste hierbij is verantwoordelijkheid, zoals ik al eerder schreef in mijn artikel over AI-beleid en governance. Volgens mij moet altijd gelden dat de (menselijke) afzenders van content volledig verantwoordelijk zijn voor de inhoud. Die kun je dan aanspreken, bestraffen of ontvolgen als ze door AI gegenereerde content niet goed hebben gecheckt.

Sommige regelgevers willen een algemene verplichting om transparant te zijn over het gebruik van generatieve AI. Zo heeft de EU net voor een AI Act gestemd met strenge regels en hoopt het dat die een wereldwijde standaard wordt, net als de GDPR-privacywetgeving. Je moet dan altijd aan de gebruiker aangeven als content gemaakt is door AI.

Maar hoe definieer je dat? Er zit een groot grijs gebied tussen een AI-chatbot en een creatief menselijk schrijfsel. Wat als mensen AI gebruiken voor drafts, die ze zelf vervolgens aanpassen? Of een door AI gestuurde zoekmachine gebruiken voor inputs? Dan is AI volgens mij een hulpmiddel en niet fundamenteel anders dan een spellingchecker.

Zelfrijdende AI

Voor autonome AI, zoals chatbots, ligt dit natuurlijk anders. Daar communiceert de AI rechtstreeks met de gebruiker, zonder tussenkomst van een menselijke moderator. Denk bijvoorbeeld aan een helpdesk of klantenservice. In deze gevallen lijkt het me niet meer dan logisch dat je de gebruiker moet melden dat hij met een AI communiceert.

Dit geldt ook voor tools als Copilot, wanneer die dan ook gaan komen. Laat je een AI-assistent de notulen en actiepunten van een online vergadering maken, een vertaling van een beleidsdocument voor een specifieke doelgroep, of een analyse van de kwartaalcijfers, wees daar dan open over. Net als nu al bij een automatisch e-mailantwoord als je op vakantie bent.

Maar veel beter, naar mijn mening, is om onderling af te spreken dat je AI-content altijd checkt voordat je het met anderen deelt. Op feitelijke juistheid, volledigheid en relevantie. Zo houd je mensen altijd in de loop en combineer je het beste van twee werelden: de efficiëntie, reikwijdte en verwerkingskracht van AI, en de originaliteit, het contextueel begrip, de emotionele intelligentie en het moreel kompas van de mens.

Tools & tips

Maar wil je die luie collega toch betrappen, of jezelf wapenen tegen fake news, dan volgen hier een paar tools en tips om door AI gegenereerde content te onderscheiden van de menselijke soort:

- GPTZero is de eerste en grootste (naar eigen zeggen). Ontwikkeld door een student op zijn spreekwoordelijke zolderkamer. Werkt prima, in mijn ervaring.

- OpenAI, de makers van ChatGPT en DALL-E, stellen zelf de AI Text Classifier beschikbaar. Die werkt ook goed, maar heeft wel minimaal 1000 woorden nodig.

- Voor plaatjes heeft bijvoorbeeld Hive een tool, die mijn DALL-E-creaties feilloos herkende.

- Vera.ai is een EU-project dat expertise op dit gebied samenbrengt en waarvan onder andere de UvA partner is.

Natuurlijk is het ook goed om zelf kritisch te blijven. Wees alert op deze punten in teksten, die kunnen wijzen op een AI-auteur:

- Foutloos geschreven

- Generieke insteek

- Geen persoonlijke noot

- Repetitief woordgebruik

- Onlogische opbouw

(Lijstje met dank aan AI!)

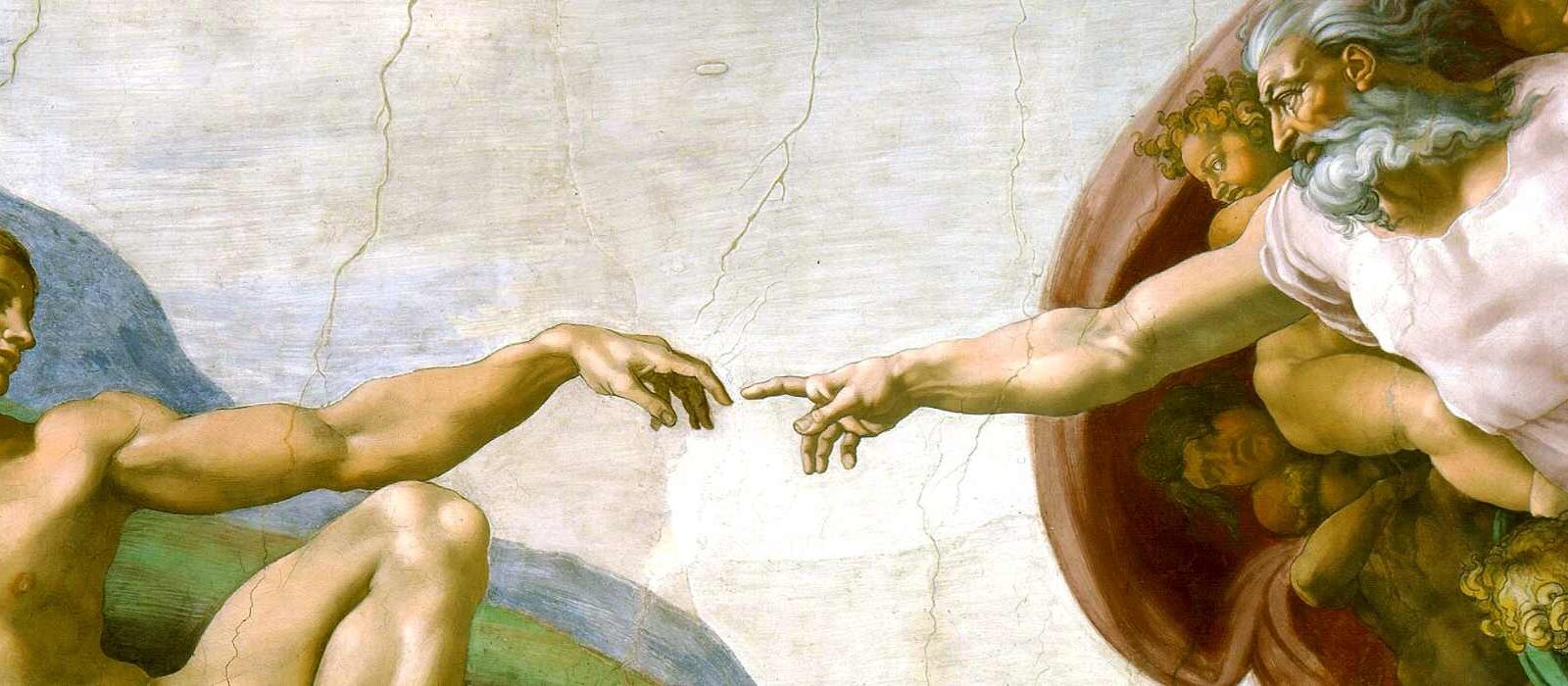

Met de explosieve groei van AI is dit wellicht een goede in- of aanvulling op de 21e eeuwse vaardigheden, die iedereen zou moeten hebben om deel te nemen in de maatschappij van de toekomst. Of misschien zelfs al in die van de holbewoners, vikingen, samoerai en cowboys!