Wat is waar? Over de PRI-Index en betrouwbaar (usability) onderzoek

Zolang (online-) onderzoek wordt toegepast voor marketingdoeleinden bestaat ook de discussie over het aantal personen dat nodig is voor een betrouwbare studie. In deze discussies voeren meningen vaak de boventoon. Moet hier niet eens een einde aan komen? Tijdens mijn Master Toegepaste Cognitieve Psychologie aan de Universiteit Utrecht (UU) begon ik al met mijn missie om antwoord te kunnen geven op de vraag naar betrouwbaar usability onderzoek. Ik ontwikkelde toen de zogeheten PRI-Index.

Voor usability testen wordt er vaak geschermd met een gouden regel. Een bekende is dat N= 5-8 voldoende om problemen op te sporen (J. Nielsen, S. Krug aangehaald in iskresearch.nl). Jawel, ik durf het aan: als regel is dit onzin. Dit hangt volledig af van de grootte van de te onderzoeken website, type bezoekers, de vraagstelling, kwaliteit, doel van de website, etc.

Eye-tracking als tool bij usability testing

Voor usability testen wordt eye-tracking vaak ingezet zodat de onderzoeker weet waar mensen kijken op een computerscherm. Dit kijkgedrag vormt dan samen met het overige (online) gedrag van de testpersoon het totale beeld van het onderzoek. Om aan deze resultaten een gegronde conclusie te kunnen ontlenen, moeten er natuurlijk wel voldoende mensen aan de test hebben meegedaan om een representatief beeld te krijgen van een specifieke populatie. Vaak zien we dat een mening, gevoel of een vergelijking van heatmaps gebruikt wordt als bewijsvoering voor deze betrouwbaarheid. Dit is echter ontoereikend en geeft geen inzicht in de onderliggende aspecten die bijdragen aan een nauwkeurige meeting.

Voor usability testen wordt eye-tracking vaak ingezet zodat de onderzoeker weet waar mensen kijken op een computerscherm. Dit kijkgedrag vormt dan samen met het overige (online) gedrag van de testpersoon het totale beeld van het onderzoek. Om aan deze resultaten een gegronde conclusie te kunnen ontlenen, moeten er natuurlijk wel voldoende mensen aan de test hebben meegedaan om een representatief beeld te krijgen van een specifieke populatie. Vaak zien we dat een mening, gevoel of een vergelijking van heatmaps gebruikt wordt als bewijsvoering voor deze betrouwbaarheid. Dit is echter ontoereikend en geeft geen inzicht in de onderliggende aspecten die bijdragen aan een nauwkeurige meeting.

PRI-Index

De PRI-Index is een statistische rekenmethode om de betrouwbaarheid van eye-tracking resultaten te berekenen. Inmiddels heb ik deze tool als business innovation manager bij Validators kunnen optimaliseren in een software applicatie die 3 belangrijke aspecten van betrouwbaarheid benadert:

- Berekenen: hoe betrouwbaar is de huidige meting?

- Voorspellen: hoeveel mensen zijn er nog nodig om een specifieke gewenste betrouwbaarheid te behalen?

- Beoordelen: hoe goed stuurt de uiting het kijkgedrag?

Hoe meer hoe beter?

Gebruik van participanten voor (eye-tracking-) onderzoeken kost geld en tijd. Men wil dus met een zo min mogelijk aantal respondenten toch een generaliseerbaar resultaat krijgen. Meer mensen toevoegen aan een test die al betrouwbaar is, is onzinnig en weggegooid geld.

Maar hoeveel mensen zijn er nu nodig voor een betrouwbaar onderzoek?

N= 25

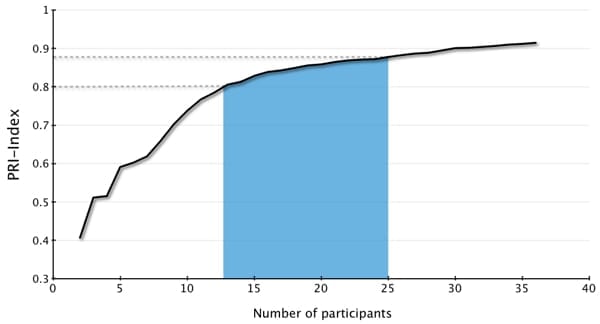

N=25 geeft een betrouwbaar resultaat van het kijkgedrag van een consument. Natuurlijk is deze regel niet zonder uitzonderingen. Betrouwbaarheid van eye-tracking resultaten hangt af van verschillende factoren zoals de lay-out van het design, het aantal onafhankelijke elementen, kleurstelling etc. Inmiddels hebben we al honderden uitingen gemeten met de PRI-Index. Als we al deze uitingen bij elkaar nemen, kunnen we zien dat voor een gemiddelde uiting 25 participanten voldoende zijn voor zeer behoorlijke betrouwbaarheid van > .8, zie de figuur hieronder.

Om methodologische redenen bestaan er in de literatuur geen eenduidige tabellen en cijfers over welke betrouwbaarheidsindex als voldoende of goed beschouwd kan worden. Toch wordt over het algemeen gezegd dat tussen de .7-.8 de betrouwbaarheid acceptabel is en tussen de .8-.9 zeer goed (DeVellis, 1991). Voldoende betrouwbaar resultaat begint dus al bij N= 12-13 (zie grafiek).

Stabiliteit kijkgedrag

Hoe kan een eye-tracking onderzoek nu al betrouwbaar zijn vanaf N= 12? Kijken we dan allemaal op dezelfde manier? Hier kan ik heel kort over zijn: ja. Ik heb het hier dan wel over de eerste paar seconden van het menselijk kijkgedrag, het scannen van de uiting. Dit is overigens vaak ook de belangrijkste periode, omdat de consument hier de beslissing maakt of er verder wordt gekeken of niet.

Menselijk kijkgedrag wordt gestuurd door 2 processen: top-down & bottom-up processen. Met name deze laatste bepaalt de hoge mate van uniformiteit van kijkgedrag. Hier wordt het kijkgedrag onbewust gestuurd door de eigenschappen van de visuele elementen, zoals kleur, contrast, beweging etc.

Doorgaans is N= 25 voor het objectief bepalen van kijkgedrag voldoende. Dit kan echter enorm verschillen. Bij sommige design tests bereiken we pas een acceptabele betrouwbaarheid vanaf N= 80. Ook dit is nuttige informatie. Er zit dan weinig overeenstemming in het kijkgedrag tussen de verschillende consumenten op de betreffende uiting, wat een indicatie is dat het kijkgedrag slecht gestuurd wordt door het design.

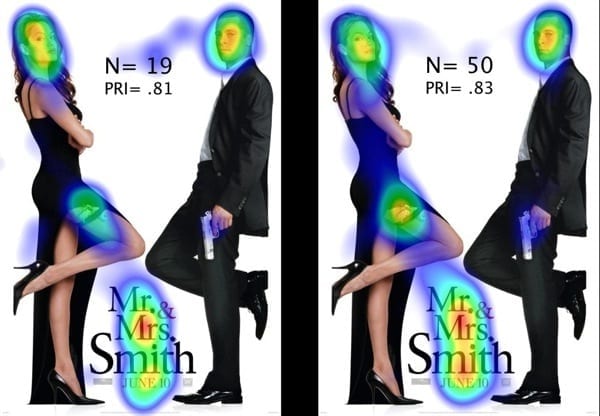

Vanaf 3 testpersonen wisten we aan de hand van de PRI-Index dat voor deze afbeelding N=19 nodig was voor een betrouwbaarheid van .80. Na werkelijk 19 personen te hebben gemeten bleek de betrouwbaarheid .81. Als we door meten tot N=50 zien we dat de betrouwbaarheid nauwelijks toeneemt.

Objectief testen

Met N=25 kan er dus objectief bekeken worden hoe de consument naar bepaalde pagina’s kijkt. De overige aspecten van een klassieke usability test (buiten webstatistieken) zijn vaak een stuk subjectiever van aard. Een testpersoon vragen waarom hij bepaald gedrag vertoont (direct of retrospectief), wat hij vindt en of hij/zij het liever anders ziet, kan nuttige informatie opleveren. Dit is zeker een nuttige opzet voor het opsporen van fouten. Er schuilt echter een gevaar in de mening van een consument. Mensen willen over het algemeen graag een mening hebben en 90% van het consumentengedrag wordt onbewust bepaald (Victor Lamme, De vrije wil bestaat niet, 2010). De gebruiker weet dus vaak niet waarom hij doet wat hij doet. En zelfs daar is hij zich vaak niet van bewust.

Betrouwbaarheid mag geen betekenis hebben zonder validiteit. Niet voor niets wordt de populariteit van neuromarketing steeds groter.