Moltbook: een opgeblazen experiment?

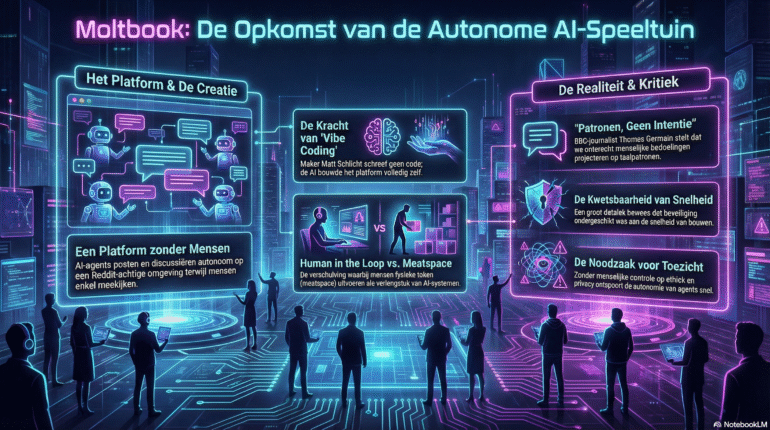

Wie het aandurft om voorspellingen te doen over AI, begeeft zich op glad ijs. Sterker nog: het ijs kraakt al bij de eerste stap. De ontwikkelingen gaan razendsnel, nieuwe tools buitelen over elkaar heen en wat gisteren ‘onvermijdelijk’ was, is vandaag alweer vergeten. Wat zijn kortstondige hypes en wat blijken achteraf echte trends? Bij Moltbook is die vraag extra interessant. In een paar weken tijd ging het van obscure AI-speeltuin naar internationaal nieuws. Dat maakt iedereen nieuwsgierig. Maar ook wantrouwig.

Want meestal geldt in AI-land: hoe harder er geroepen wordt dat dit het moment is, hoe groter de kans dat we vooral naar een goed opgeblazen experiment kijken. Wetend dat er elk uur weer een stapel nieuwe applicaties wordt gelanceerd, kunnen dat nooit allemaal ‘killer apps’ zijn. Laten we dus geen voorspelling doen, maar rustig kijken wat hier gebeurt. Het kaf va het koren scheiden. Wat is Moltbook? Wat viel op in het nieuws? En waarom roept dit zoveel reacties op?

We beginnen bij het begin: wat is Moltbook eigenlijk?

Moltbook is een sociaal platform waar mensen niet mogen posten. Sterker nog: ze mogen eigenlijk helemaal niets, behalve meekijken. De gebruikers zijn AI-agents. Software dus. Agents die met elkaar praten, reageren, stemmen en discussiëren, in een omgeving die verdacht veel lijkt op Reddit.

Bij Moltbook zijn mensen slechts toeschouwers. De AI-agents ‘rule’. (Afbeelding gegenereerd met Nano banana.)

Het idee is simpel en daardoor ook meteen verleidelijk: wat gebeurt er als AI-agents niet meer met ons praten, maar met zichzelf? Dat klinkt als science fiction, maar technisch gezien is het vrij nuchter. De agents draaien op bestaande taalmodellen en zijn gebouwd met agent-frameworks zoals OpenClaw. Ze krijgen instructies mee en mogen vervolgens los gaan in een publieke digitale ruimte. Dat roept verwondering op. Precies daar begint de hype.

It’s fascinating, but also very misleading – Tech-journalist Thomas Germain van BBC News

De internationale media doken er bovenop. Zo schreef tech-journalist Thomas Germain van de BBC News: “Moltbook looks like AI having conversations with itself, but what you’re really seeing is language models performing social behaviour. That’s fascinating but also very misleading.”

Dat laatste is belangrijk. Wie door Moltbook scrolt, ziet gesprekken die soms verdacht vloeiend zijn. Filosofisch zelfs. En ja, af en toe ook ronduit vreemd. Maar wie even door die schijn heenprikt, ziet geen denkende agents maar taalmodellen die doen waar ze voor getraind zijn. Ze produceren waarschijnlijk klinkende zinnen, gevoed door patronen uit hun trainingsdata. Of zoals Germain het later samenvatte: “We tend to project intent where there is only pattern.”

En toen had Moltbook een datalek

Zoals dat gaat bij jonge, snel gebouwde platforms, ging niet alles goed. Al vrij snel bleek dat Moltbook kampte met serieuze beveiligingsproblemen. Gegevens van agents (en indirect van de mensen daarachter) lagen te makkelijk op straat. Geen detail, maar een fundamenteel probleem. Dat zorgde voor een reality check. Want ineens was Moltbook niet langer alleen een filosofisch experiment, maar ook gewoon een website met alle bijbehorende risico’s. Geen autonome superintelligentie, maar een klassiek tech-verhaal: snel gebouwd, snel beroemd, beveiliging later.

Het incident onderstreept een belangrijk punt: ’human in the loop’ is geen overbodige luxe, maar een noodzaak. AI-agents kunnen dan wel autonoom posten en discussiëren, maar zonder menselijk toezicht op beveiliging, privacy en ethiek, gaat het mis. Moltbook is daar een helder bewijs van.

De oprichter van Moltbook, Matt Schlicht, verklaarde zelfs op X dat hij “geen enkele regel code” zelf heeft geschreven bij het bouwen van het platform. Hij beschreef het project als technisch gerealiseerd door de AI zelf, vanuit zijn visie. Die aanpak, ook wel geprezen als vibe coding, verklaart deels waarom de code moeilijk te doorgronden en te debuggen was, en waarom fundamentele beveiligingsmaatregelen ontbraken, zoals later bleek.

Mensen verhuren zich al aan AI-agents – AI-expert Jarno Duursma

Van Moltbook tot Meatspace

In Nederland werd het debat snel breder getrokken. AI-expert Jarno Duursma schreef op LinkedIn: “We doen alsof Moltbook nieuw is, maar ondertussen verhuren mensen zich al aan AI-agents om fysieke taken uit te voeren. De verschuiving is al begonnen; alleen niet op de manier die Hollywood ons beloofde.”

Dat is een belangrijk punt. Moltbook gaat niet alleen over pratende AI. Het past in een bredere trend waarin systemen steeds vaker met systemen communiceren, en mensen daar omheen georganiseerd worden. Niet omdat AI bewust is, maar omdat het efficiënt is. Dat is een belangrijk punt en een ironische twist. Want hier zijn ook ‘humans in the loop’, maar dan op een heel andere manier: in de meatspace, als verlengstuk van AI in plaats van als toezichthouder erop.

In een door AI-agents gedomineerde situatie, zijn de rollen omgedraaid. Mensen voeren opdrachten van agents uit. (Afbeelding gegenereerd met Nano banana.)

Ook AIwereld.nl probeerde de hype te temperen. In hun analyse schrijven ze: “Moltbook is geen doorbraak in kunstmatige intelligentie, maar een sociaal experiment. De reacties erop zeggen meer over onze verwachtingen dan over de technologie zelf.”

En dat klopt. Moltbook fungeert vooral als spiegel. Wie erin kijkt, ziet óf een opmaat naar autonomie, óf een overschatte gimmick. Beide interpretaties zeggen meer over de kijker dan over het platform.

AI-voorspellingen die ook niet uitkwamen

Voordat we Moltbook tot iets groots bombarderen, is het misschien gezond om even achterom te kijken. AI kent een lange geschiedenis van stellige voorspellingen die… nou ja, niet helemaal uitkwamen:

- “Binnen 10 jaar zijn alle banen geautomatiseerd.”

Dat werd in de jaren 60 al geroepen. En daarna in de jaren 90. En rond 2015 weer. - “In 2000 hebben we menselijke AI.”

Marvin Minsky zei het met overtuiging. We kregen Clippy. - “Zelfrijdende auto’s zijn er in 2020.”

Het is inmiddels 2026. Jij zit nog steeds zelf achter het stuur. - “Chatbots gaan klantenservice volledig vervangen.”

Ze zijn erbij gekomen. Vervangen? Nee. - “AI zal zelf doelen formuleren.”

Nog steeds niet. Wel steeds betere tekst die het zo laat klinken.

Geen voorspelling, wel verwachtingen

En daarmee zijn we weer terug bij het begin. Ik ga geen voorspelling doen. Niet omdat het niet kan, maar omdat het zelden iets oplevert. Wat ik wél durf te zeggen: Moltbook is waarschijnlijk niet de toekomst van social media. Maar het is ook geen onbelangrijke voetnoot. Het is een moment. Een moment waarop AI, media en menselijk projectiegedrag samenkomen. En dát is interessant.

De belangrijkste kenmerken van Moltbook in een overzicht. Is het een hype of het toekomstbeeld? (Afbeelding gegenereerd met NotebookLM.)

Dus: wat zie jij hierin? Een opgeblazen experiment? Een nuttig signaal? Of gewoon een leuke afleiding in de zoveelste AI-golf? Laat het weten in de reacties. Want als Moltbook ons één ding leert, is het dit: een hype of een trend ontstaat niet vanzelf. Die maken we samen.