Navigeren met je ogen, kan dat?

Hoe zou het zijn om je handen vrij te hebben bij het navigeren op een website? Of achteruit te kunnen gaan zitten en rustig van een scherm te lezen en zonder muis, toetsenbord of het scherm aan te raken verder te kunnen scrollen? Klinkt dit futuristisch? Dankzij de doorontwikkeling van eyetracking is het voor mensen met een handicap al langer een realiteit. Maar ook voor de gewone consument komt het nu dichterbij.

Eyetracking

Eyetracking

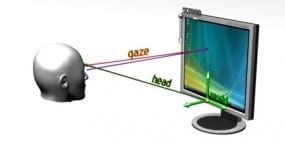

Bij eyetracking wordt door de weerkaatsing van infraroodlicht vastgesteld waar de ogen precies naar kijken. Dit kan onder andere gebruikt worden om te bepalen waar bezoekers wel of niet naar kijken op een website, in welke volgorde men kijkt en tussen welke zaken bezoekers bijvoorbeeld heen en weer kijken en ze dus over twijfelen. De techniek is echter zo ontwikkeld dat deze niet alleen te gebruiken is als output voor onderzoek, maar ook als input voor de besturing van computers.

‘Gaze interaction’ op de computer

Begin maart heeft Tobii een laptop gepresenteerd waarin eyetracking geïntegreerd is. De oogbewegingen worden op precies dezelfde manier gemeten als bij de opstelling die wij gebruiken voor ons onderzoek. Maar nu worden de oogbewegingen gebruikt om de computer te besturen.

Toepassingen

Tobii heeft een demofilmpje gemaakt, waarin het bedrijf een aantal toepassingen laat zien die al ontwikkeld zijn. Een aantal voorbeelden:

- Het selecteren van een venster door ernaar te kijken. Op de foto hierboven is te zien dat je een bepaalde knop in moet drukken waardoor alle vensters te zien zijn. Door te kijken naar het venster dat je wilt openen en de knop van het toetsenbord los te laten komt het gewenste venster volledig in beeld.

- Met de ogen kijken naar een punt waar je de muiscursor naartoe wilt bewegen en vervolgens de muis alleen maar aan raken om de cursor ook daadwerkelijk naar dat punt te verplaatsen.

- Het automatisch naar beneden scrollen bij het lezen van een tekst doordat het scherm ‘ziet’ waar je bent met lezen.

- Het activeren van belangrijke informatie op de plaats waar je op dat moment kijkt (als voorbeeld wordt gegeven het activeren van de Caps Lock als je aan het typen bent; op de plaats waar je kijkt komt even de tekst ‘Caps Lock on’ in beeld).

- Door naast het scherm te kijken activeert een menu waarin bijvoorbeeld recente documenten of afbeeldingen geselecteerd kunnen worden.

Nog niet zelfstandig

Tobii presenteert de eyetracking als een aanvulling op het toetsenbord en de muis. Dus om daadwerkelijk een actie uit te voeren, bijvoorbeeld om een bestand te openen, is het nodig om op het toetsenbord of de muis te klikken. Ook typen gebeurt nog gewoon via het toetsenbord.

Het is bovendien niet mogelijk om volledig op eyetracking te vertrouwen: je kijkt niet altijd gericht naar een bepaald punt en ogen gaan vaak zo snel op en neer dat het niet mogelijk is om hier helemaal van afhankelijk te zijn. Bovendien zou het heel vervelend zijn als je op elk punt waar je kijkt iets activeert.

‘Gaze interaction’ op mobiele apparaten

Op het moment wordt er ook veel onderzoek gedaan naar ‘gaze interaction’ op de mobiele telefoon. Door professor Andrew Campbell van Dartmouth College is bijvoorbeeld vorig jaar het programma EyePhone ontwikkeld dat kan draaien op een Nokia 810. Hiermee kan met de ogen op de smartphone input geleverd worden om de mobiele telefoon te bedienen.

Eyetracken van een mobiele telefoon brengt echter een aantal problemen met zich mee:

- Telefoons worden buiten gebruikt waardoor de reflectie van het zonlicht het volgen van de ogen kan bemoeilijken

- Bij telefoons bewegen niet alleen het hoofd en de ogen, maar ook de telefoon zelf. Bij een computer of laptop staat in elk geval het apparaat stil.

- Het scherm van een mobiele telefoon is veel kleiner dan van een computer, hierdoor hoeven de ogen niet zoveel te bewegen en moet de registratie van de oogbewegingen juist heel precies zijn.

De EyePhone is dan ook maar ongeveer 76% accuraat als de gebruiker bij daglicht stilt staat en 60% als hij loopt. Dat is dus nog niet betrouwbaar genoeg om alleen de oogbewegingen als input te gebruiken. De techniek moet nog flink doorontwikkeld worden om daadwerkelijk toegepast te kunnen worden in mobiele telefoons.

Usability

De techniek om een computer en mobiele apparaten te besturen met de ogen komt echter steeds dichterbij voor de gewone consument. Het is dan ook belangrijk om na te gaan denken over de punten waarmee rekening gehouden moet worden bij het ontwerpen van (mobiele) websites en apps. Zo moeten knoppen bijvoorbeeld groot genoeg zijn om goed met de ogen te kunnen selecteren via fixatie, maar weer niet te groot zodat ze teveel ruimte innemen.

Welke mogelijkheden en aandachtspunten zie jij? Ik ben benieuwd!

Bronnen

- Drewes, H., A. De Luca & A. Schmidt (2007) Eye-Gaze Interaction for Mobile Phones. Proceedings of Mobility ’07 (pdf), New York

- Tobii (2011) Tobii unveils the world’s first eye-controlled laptop

- Grifantini, K (24-5-2010) Eye Tracking for Mobile Control. In: Technology Review

Employee Experience

Employee Experience