Weet welke pagina’s niet zijn geïndexeerd door Google!

Regelmatig komen klanten met de volgende vraag: ‘Waarom zijn niet alle pagina’s geïndexeerd in Google?’ Om deze vraag te kunnen beantwoorden en er vervolgens iets aan te kunnen doen, moet je eerst weten welke pagina’s niet zijn geïndexeerd. In dit artikel een aantal tips om hier achter te komen.

Onbetrouwbare resultaten

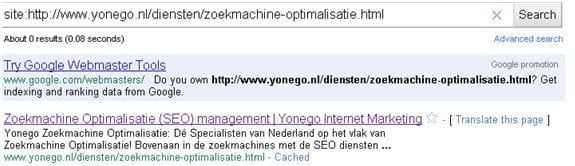

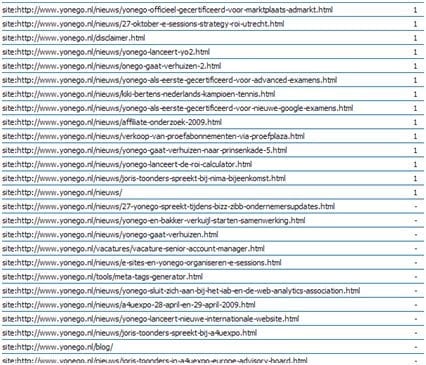

Veelal geven klanten de volgende query in Google in: ‘site:https://www.website.nl’. Deze methode is verre van betrouwbaar: de cijfers geven overal een ander resultaat, zoals duidelijk te zien is in onderstaande 3 afbeeldingen.

Hier 94 resultaten:

Een paar pagina’s verder:

Het Google Webmaster Centrum geeft vervolgens weer iets anders aan:

Je kan je natuurlijk afvragen: wil je dit eigenlijk wel weten? Over het algemeen is het toch veel belangrijker dat je aan de slag gaat met pagina’s die bezoekers krijgen vanuit de zoekmachines?

Dat is in principe waar, maar pagina’s die niet geïndexeerd zijn, krijgen natuurlijk ook geen bezoekers uit de zoekmachines. En dit kunnen nogal eens een hoop pagina’s en bezoekers zijn. Daarnaast zit hier een achterliggende gedachte achter die nog veel simpeler is.

Waarom zijn ze niet geïndexeerd?

Als je het antwoord weet te vinden op deze vraag, stel je een veel belangrijker onderdeel van je website aan de kaak. Wat gaat er mis wanneer Google mijn pagina’s niet interessant genoeg vindt om op te nemen in de zoekmachines? Wat voor problemen zijn er die ik kan oplossen om meer waarde te geven aan deze pagina’s voor zowel de zoekmachines als de gebruikers? De opties zijn namelijk legio: interne linking, duplicate content, geen backlinks etc.

Voordat je het juiste antwoord kan geven op deze vraag, moet je eerst even kijken naar welke pagina’s niet geïndexeerd zijn. Dit is over het algemeen moeilijker dan verwacht. Het Google Webmaster Centrum geeft deze informatie dus helaas niet weer. Verder geeft ‘site:https://www.yonego.nl’ dit ook niet aan, zeker niet met de onduidelijke data.

Hierop kan een zeer klein trucje het antwoord zijn. De volgende Query in Google geeft weer of een pagina wel of niet geïndexeerd is op pagina niveau:

‘site:https://www.yonego.nl/diensten/zoekmachine-optimalisatie.html’

Inurl

Je zou ook het commando ‘inurl:’ kunnen gebruiken om dit te weten te komen. Dit commando geeft echter verkeerde resultaten op URL’s met spaties, dit wordt herschreven naar %20. Onderstaande URL’s geven dan geen resultaten als we ‘inurl:’ zouden gebruiken in plaats van site:

‘site:https://www.lachmee.nl/Teksten/tekst%20windowsautos.htm’

Het handmatig nalopen van alle URL’s vergt teveel tijd. Je kan dit wel automatisch doen via een rank-checker. Dan zijn die dingen toch nog ergens goed voor! Zelf heb ik het getest met zowel WebCEO als Advanced Web Ranking en beide programma’s geven een goed beeld van de indexatie van de URL’s.

Deze combinatie van het combineren van een programma met een Query in Google kan bepaalde zaken dus erg inzichtelijk maken die anders moeilijker inzichtelijk zouden zijn. Ik ben benieuwd of jullie nog vernuftige manieren hebben om uit dit soort combinaties leuke informatie te halen.

Employee Experience

Employee Experience